Elon Musk mua hàng nghìn GPU cho Dự án AI sáng tạo của Twitter

Mặc dù ủng hộ việc ngừng đào tạo AI trong toàn ngành, nhưng Elon Musk được cho là đã khởi động một dự án trí tuệ nhân tạo lớn trên Twitter. Công ty đã mua khoảng 10.000 GPU và tuyển dụng nhân tài AI từ DeepMind cho dự án liên quan đến mô hình ngôn ngữ lớn (LLM), Business Insider đưa tin.

Một nguồn thạo tin cho biết dự án AI của Musk vẫn đang trong giai đoạn đầu. Tuy nhiên, theo một cá nhân khác, việc có được một lượng đáng kể sức mạnh tính toán bổ sung cho thấy sự cống hiến của anh ấy đối với việc thúc đẩy dự án. Trong khi đó, mục đích chính xác của AI tổng quát vẫn chưa rõ ràng, nhưng các ứng dụng tiềm năng bao gồm cải thiện chức năng tìm kiếm hoặc tạo nội dung quảng cáo được nhắm mục tiêu.

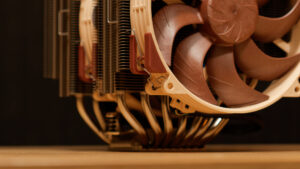

Tại thời điểm này, vẫn chưa biết Twitter đã mua phần cứng chính xác nào. Tuy nhiên, Twitter được cho là đã chi hàng chục triệu đô la cho các GPU điện toán này bất chấp các vấn đề tài chính đang diễn ra của Twitter, mà Musk mô tả là “tình hình tài chính không ổn định”. Các GPU này dự kiến sẽ được triển khai tại một trong hai trung tâm dữ liệu còn lại của Twitter, với Atlanta là điểm đến khả dĩ nhất. Thật thú vị, Musk đã đóng cửa trung tâm dữ liệu chính của Twitter ở Sacramento vào cuối tháng 12, điều này rõ ràng đã làm giảm khả năng tính toán của công ty.

Ngoài việc mua phần cứng GPU cho dự án AI tổng thể của mình, Twitter đang thuê thêm các kỹ sư. Đầu năm nay, công ty đã tuyển dụng Igor Babuschkin và Manuel Kroiss, các kỹ sư từ công ty nghiên cứu AI DeepMind, một công ty con của Alphabet. Musk đã tích cực tìm kiếm tài năng trong ngành AI để cạnh tranh với ChatGPT của OpenAI kể từ ít nhất là vào tháng Hai.

OpenAI đã sử dụng GPU A100 của Nvidia để đào tạo bot ChatGPT của mình và tiếp tục sử dụng các máy này để chạy nó. Hiện tại, Nvidia đã tung ra phiên bản kế nhiệm của A100, GPU tính toán H100 của họ nhanh hơn nhiều lần với cùng mức công suất. Twitter có thể sẽ sử dụng Hopper H100 của Nvidia hoặc phần cứng tương tự cho dự án AI của mình, mặc dù chúng tôi đang suy đoán ở đây. Xem xét rằng công ty vẫn chưa xác định dự án AI của mình sẽ được sử dụng cho mục đích gì, thật khó để ước tính có thể cần bao nhiêu GPU Hopper.

Khi các công ty lớn như Twitter mua phần cứng, họ mua với mức giá đặc biệt khi họ mua hàng nghìn đơn vị. Trong khi đó, khi được mua riêng từ các nhà bán lẻ như CDW, các bo mạch chủ H100 của Nvidia có thể có giá trên 10.000 USD/chiếc, điều này cho thấy công ty có thể đã chi bao nhiêu tiền cho phần cứng cho sáng kiến AI của mình.