Các công ty Trung Quốc phá vỡ các lệnh trừng phạt AI của Hoa Kỳ với GPU cũ hơn, tinh chỉnh phần mềm

Sau khi các công ty Trung Quốc mất quyền truy cập vào GPU điện toán A100 và H100 hàng đầu của Nvidia, có thể được sử dụng để đào tạo các mô hình AI khác nhau, họ phải tìm cách đào tạo chúng mà không cần sử dụng phần cứng tiên tiến nhất. Tờ Wall Street Journal đưa tin, để bù đắp cho việc thiếu GPU mạnh mẽ, các nhà phát triển mô hình AI của Trung Quốc đang đơn giản hóa các chương trình của họ để giảm yêu cầu và sử dụng tất cả phần cứng máy tính mà họ có thể kết hợp.

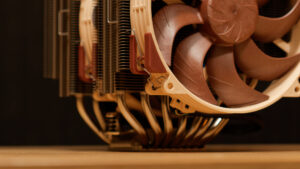

Nvidia không thể bán GPU điện toán A100 và H100 của mình cho các thực thể Trung Quốc như Alibaba hoặc Baidu mà không nhận được giấy phép xuất khẩu từ Bộ Thương mại Hoa Kỳ (và bất kỳ ứng dụng nào gần như chắc chắn sẽ bị từ chối). Vì vậy, Nvidia đã phát triển các bộ xử lý A800 và H800 mang lại hiệu suất giảm và đi kèm với các khả năng NVLink bị hạn chế, điều này hạn chế khả năng xây dựng các hệ thống đa GPU hiệu suất cao vốn được yêu cầu để đào tạo các mô hình AI quy mô lớn.

Ví dụ: mô hình ngôn ngữ quy mô lớn đằng sau ChatGPT của OpenAI yêu cầu từ 5.000 đến 10.000 GPU A100 của Nvidia để đào tạo, theo ước tính của các nhà phân tích UBS, báo cáo của WSJ. Theo Yang You, giáo sư tại Đại học Quốc gia Singapore và người sáng lập HPC, vì các nhà phát triển Trung Quốc không có quyền truy cập vào A100 nên họ sử dụng kết hợp A800 và H800 kém hiệu năng hơn để đạt được thứ gì đó giống với hiệu suất của GPU hiệu năng cao hơn của Nvidia. -Công nghệ AI. Vào tháng 4, Tencent đã giới thiệu một cụm máy tính mới sử dụng H800 của Nvidia để đào tạo mô hình AI quy mô lớn. Cách tiếp cận này có thể tốn kém, vì các công ty Trung Quốc có thể cần số H800 nhiều gấp ba lần so với các đối tác Hoa Kỳ của họ sẽ yêu cầu H100 để có kết quả tương tự.

Do chi phí cao và không thể có được tất cả các GPU mà họ cần, các công ty Trung Quốc đã thiết kế các phương pháp để đào tạo các mô hình AI quy mô lớn trên các loại chip khác nhau, điều mà các công ty có trụ sở tại Hoa Kỳ hiếm khi thực hiện do những thách thức kỹ thuật và lo ngại về độ tin cậy. Ví dụ: các công ty như Alibaba, Baidu và Huawei đã khám phá việc sử dụng kết hợp A100, V100 và P100 của Nvidia và Ascends của Huawei, theo các tài liệu nghiên cứu được WSJ đánh giá.

Mặc dù có nhiều công ty ở Trung Quốc đang phát triển bộ xử lý cho khối lượng công việc AI, nhưng phần cứng của họ không được hỗ trợ bởi các nền tảng phần mềm mạnh mẽ như CUDA của Nvidia, đó là lý do tại sao các máy dựa trên chip như vậy được cho là “dễ bị hỏng”.

Ngoài ra, các công ty Trung Quốc cũng tích cực hơn trong việc kết hợp các kỹ thuật phần mềm khác nhau để giảm yêu cầu tính toán khi đào tạo các mô hình AI quy mô lớn, một cách tiếp cận vẫn chưa đạt được sức hút trên toàn cầu. Bất chấp những thách thức và những cải tiến đang diễn ra, các nhà nghiên cứu Trung Quốc đã đạt được một số thành công trong các phương pháp này.

Trong một bài báo gần đây, các nhà nghiên cứu của Huawei đã trình diễn việc đào tạo mô hình ngôn ngữ lớn thế hệ mới nhất của họ, PanGu-Σ, chỉ sử dụng bộ xử lý Ascend và không có GPU tính toán Nvidia. Mặc dù có một số thiếu sót, nhưng mô hình này đã đạt được hiệu suất cao nhất trong một số nhiệm vụ bằng tiếng Trung, chẳng hạn như đọc hiểu và kiểm tra ngữ pháp.

Các nhà phân tích cảnh báo rằng các nhà nghiên cứu Trung Quốc sẽ gặp nhiều khó khăn hơn nếu không tiếp cận được với chip H100 mới của Nvidia, chip này bao gồm một tính năng nâng cao hiệu suất bổ sung, đặc biệt hữu ích cho việc đào tạo các mô hình giống như ChatGPT. Trong khi đó, một bài báo xuất bản năm ngoái bởi Baidu và Phòng thí nghiệm Peng Cheng đã chứng minh rằng các nhà nghiên cứu đang đào tạo các mô hình ngôn ngữ lớn bằng một phương pháp có thể khiến tính năng bổ sung trở nên không liên quan.

“Nếu nó hoạt động tốt, họ có thể phá vỡ các lệnh trừng phạt một cách hiệu quả,” Dylan Patel, nhà phân tích chính tại SemiAnalysis, được cho là đã nói như vậy.