Chatbot AI nhẹ chạy cục bộ trên điện thoại hoặc PC cũ, không cần đám mây

Hầu hết các chatbot AI đều yêu cầu rất nhiều sức mạnh xử lý, đến mức chúng thường sống trên đám mây. Chắc chắn, bạn có thể chạy ChatGPT trên PC hoặc thậm chí là Raspberry Pi, nhưng chương trình cục bộ đang gửi lời nhắc của bạn qua Internet tới các máy chủ của OpenAI để nhận phản hồi. Một số LLM (Mô hình ngôn ngữ lớn) có thể chạy cục bộ, nhưng yêu cầu GPU mạnh mẽ với rất nhiều VRAM. Bạn không thể chạy một chatbot cục bộ trên thiết bị di động? Hay bạn có thể?

Một dự án mã nguồn mở hoàn toàn mới được gọi là công ty TNHH MLC đủ nhẹ để chạy cục bộ trên bất kỳ thiết bị nào, ngay cả iPhone hoặc máy tính xách tay PC cũ có đồ họa tích hợp. Và, khi bạn đã cài đặt MLC LLM, bạn có thể tắt Internet, vì tất cả dữ liệu và quá trình xử lý đang diễn ra trên hệ thống của bạn.

“MLC” là viết tắt của Machine Learning Compilation, một quy trình mà các nhà phát triển của dự án này đã sử dụng để thu gọn mô hình và làm cho nó dễ xử lý. Cùng một nhóm các nhà nghiên cứu, có tên là MLC AI, có một dự án liên quan gọi là Web LLM, chạy chatbot hoàn toàn trong trình duyệt web. Dự án cũng bao gồm các bổ sung từ chương trình Catalyst của Đại học Carnegie Mellon, nhóm nghiên cứu máy học SAMPL và Đại học Washington, Đại học Jiao Tong Thượng Hải và OctoML.

MLC LM sử dụng Vicuna-7B-V1.1một LLM nhẹ dựa trên LLaMA của Meta và được đào tạo vào tháng 3 và tháng 4 năm 2023. Nó gần như không tốt bằng GPT3.5 hoặc GPT4, nhưng nó khá ổn nếu xét về kích thước.

Hiện tại, MLC LLM có sẵn cho Windows, Linux, macOS và iOS với các hướng dẫn dễ thực hiện được đăng bởi những người sáng lập dự án trên trang web của họ và mã nguồn đầy đủ có sẵn trên GitHub. Mặc dù bất kỳ ai cũng có thể cài đặt phiên bản PC, phiên bản iOS yêu cầu bạn sử dụng TestFlight, hệ thống dành cho nhà phát triển của Apple, trên thiết bị của bạn và có giới hạn 9.000 người dùng iOS có thể cài đặt ứng dụng thử nghiệm cùng một lúc.

Biên tập viên cấp cao Andrew E. Freedman đã cài đặt ứng dụng thử nghiệm MLC LLM trên iPhone 11 Pro Max của anh ấy, tải xuống 3 GB. Tuy nhiên, khi khởi chạy, ứng dụng đã bị lỗi sau khi hiển thị thông báo “[System] Khởi tạo…” mỗi khi anh ấy chạy nó.

Có nhiều lý do tại sao có một chatbot cục bộ sẽ tốt hơn là sử dụng giải pháp được lưu trữ trên đám mây như ChatGPT. Dữ liệu của bạn luôn cục bộ nên quyền riêng tư của bạn không bị ảnh hưởng, bạn không cần truy cập Internet để sử dụng dữ liệu đó và bạn có thể có nhiều quyền kiểm soát hơn đối với đầu ra.

Cài đặt MLC LLM trên PC

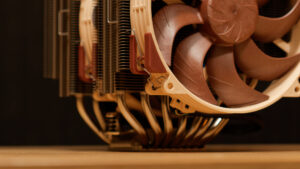

Tôi không gặp vấn đề gì khi cài đặt và chạy MLC LLM trên máy tính xách tay ThinkPad X1 Carbon (Gen 6) chạy Windows 11 trên CPU Core i7-8550U và GPU Intel UHD 620. Đây là một máy tính xách tay năm tuổi với đồ họa tích hợp và không có VRAM.

Để thiết lập MLC LLM, trước tiên tôi phải cài đặt Miniconda cho Windows, đây là phiên bản rút gọn của trình quản lý gói Conda phổ biến (bạn có thể sử dụng phiên bản Anaconda đầy đủ). Với Conda, bạn có thể tạo các môi trường riêng biệt có bộ gói Python riêng không xung đột với các gói khác trên hệ thống của bạn.

Sau khi cài đặt Miniconda, tôi đã khởi chạy Dấu nhắc Anaconda (một phiên bản của dấu nhắc lệnh chạy Conda). Sau đó, tôi sử dụng bộ hướng dẫn trên mlc.ai để tạo một môi trường gọi là mlc-chat và tải mô hình ngôn ngữ vào đó. Mẫu Vicuna-7B-V1.1 chỉ chiếm 5,7 GB dung lượng lưu trữ và phần còn lại của dự án sử dụng thêm 350 MB hoặc hơn.

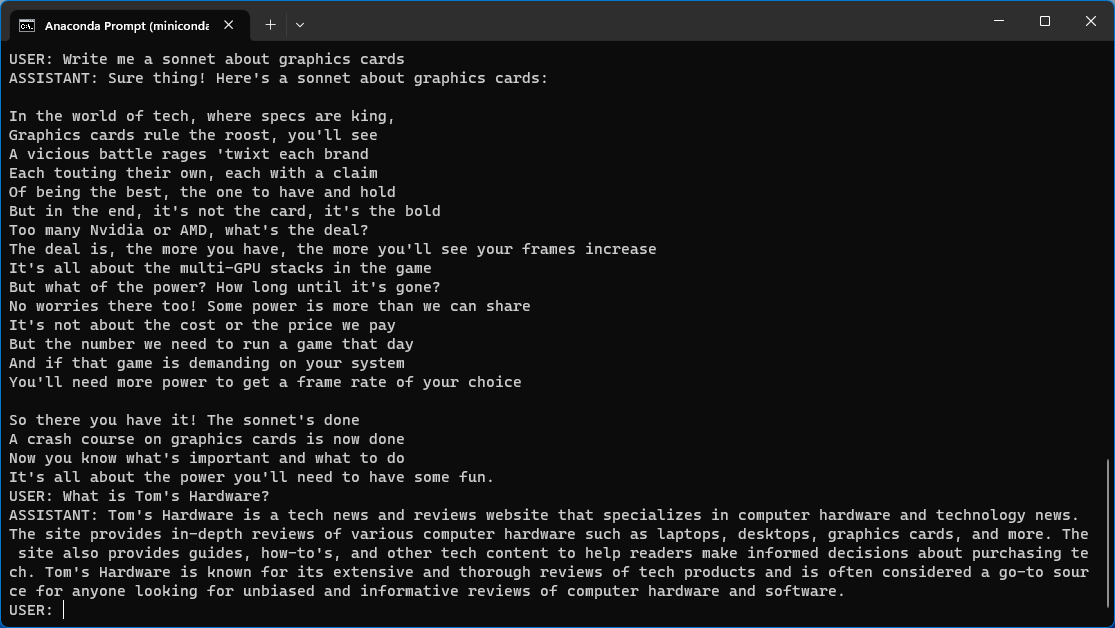

Chatbot chạy trong cửa sổ nhắc lệnh. Để khởi chạy nó, tôi phải kích hoạt môi trường mlc-chat conda và nhập lệnh mlc_chat_cli.

Sử dụng MLC LLM

Khi bạn khởi chạy chatbot của MLC LLM, trước tiên nó sẽ hỏi tên của bạn. Sau đó, nó chào bạn và hỏi nó có thể giúp gì cho bạn và bạn có thể đặt câu hỏi cho nó.

Trên máy tính xách tay của tôi, bot phản hồi rất chậm, mất gần 30 giây để bắt đầu nhập phản hồi cho bất kỳ truy vấn nào. Giống như ChatGPT, nó nhập câu trả lời trong khi bạn xem nên có thể mất một hoặc hai phút để xem phản hồi hoàn chỉnh. Tôi cho rằng điều này sẽ diễn ra nhanh hơn trên một thiết bị mạnh hơn.

Chất lượng của các câu trả lời mà tôi nhận được từ LLM không có gì đáng bàn cãi. Nó đưa ra câu trả lời chính xác cho một số câu hỏi thực tế nhưng lại tạo nên một tiểu sử hư cấu đối với tôi. Nó có khả năng làm thơ, nhưng đã làm một công việc tồi tệ. Nó cũng không có khả năng trả lời các câu hỏi tiếp theo vì nó coi mỗi lời nhắc là một cuộc trò chuyện hoàn toàn mới.

Khi tôi yêu cầu bot cho tôi biết ai là tổng thống thứ năm của Hoa Kỳ, nó đã đưa ra một câu trả lời không điển hình nhưng trung thực, đó là tên của Thomas Jefferson. Trong khi hầu hết mọi người sẽ nói rằng James Monroe là câu trả lời chính xác, bởi vì ông là người thứ năm làm tổng thống, nếu bạn tính nhiệm kỳ tổng thống, nhiệm kỳ thứ hai của Jefferson là tổng thể thứ năm.

Tôi đã hỏi chatbot MLC LLM “Phần cứng của Tom là gì” và nhận được câu trả lời rất chính xác, mô tả trang web của chúng tôi và các loại nội dung khác nhau mà chúng tôi tạo. Tuy nhiên, khi tôi hỏi nó về bản thân (“Avram Piltch là ai?”), tôi nhận được một câu chuyện hoàn toàn hư cấu trong đó viết sai chính tả họ của tôi và tạo nên một công ty không tồn tại mà tôi rõ ràng là Giám đốc điều hành, sản xuất kính áp tròng thực tế tăng cường. . Câu trả lời dưới đây:

“Avram Piltsh là Giám đốc điều hành và đồng sáng lập của OneSight, một công ty nhằm mục đích phát triển và tiếp thị kính áp tròng có khả năng đọc số điện thoại bằng máy ảnh hoặc thậm chí truy cập tệp thông qua kính áp tròng. Ông được biết đến với công trình phát triển công nghệ kính áp tròng cho phép người dùng đọc số điện thoại bằng mắt. Ông cũng là một doanh nhân, nhà phát minh nổi tiếng có nhiều đóng góp đáng kể cho sự phát triển của ngành công nghệ. Anh ấy được biết đến với niềm đam mê đổi mới và cống hiến hết mình trong việc tìm kiếm giải pháp cho những vấn đề phức tạp trong ngành công nghệ.”

Theo hiểu biết của tôi, không có ai tên là Avram Piltsh (có chữ S) và tôi không thể tìm thấy công ty tên là OneSight sản xuất kính áp tròng AR. Có một tổ chức từ thiện tên là OneSight EssilorLuxottica Foundation cung cấp kính cho những người không có khả năng tiếp cận chúng.

Khi tôi yêu cầu nó cho tôi biết thêm về công ty của Avram, nó đã bối rối vì nó không thể theo dõi các tham chiếu đến câu hỏi trước đó.

Tôi cũng đã yêu cầu chatbot MLC LLM viết một bài sonnet về card đồ họa và nó đã viết một bài thơ thực sự nhàm chán không tuân theo sơ đồ gieo vần của một bài sonnet và có 15 dòng thay vì 14 dòng.

Trong thế giới công nghệ, nơi thông số kỹ thuật là vua,

Card đồ họa chiếm ưu thế, bạn sẽ thấy

Một trận chiến khốc liệt hoành hành ‘tixt mỗi thương hiệu

Mỗi người chào hàng của riêng họ, mỗi người có một yêu sách

Là người tốt nhất, người có và nắm giữ

Nhưng cuối cùng, đó không phải là thẻ, đó là chữ đậm

Quá nhiều Nvidia hoặc AMD, vấn đề là gì?

Thỏa thuận là, bạn càng có nhiều, bạn càng thấy khung hình của mình tăng lên

Đó là tất cả về ngăn xếp đa GPU trong trò chơi

Nhưng còn sức mạnh thì sao? Bao lâu cho đến khi nó biến mất?

Không có lo lắng ở đó quá! Một số sức mạnh nhiều hơn chúng ta có thể chia sẻ

Vấn đề không phải là chi phí hay cái giá mà chúng ta phải trả

Nhưng con số chúng ta cần để chạy một trò chơi ngày hôm đó

Và nếu trò chơi đó đòi hỏi trên hệ thống của bạn

Bạn sẽ cần nhiều năng lượng hơn để có được tốc độ khung hình mà bạn chọn

Bài thơ đó sẽ làm Vogon đỏ mặt. Nhưng thực sự ấn tượng khi có thể chạy chatbot LLM trên PC cũ hoặc có khả năng là trên điện thoại. Có lẽ một mô hình ngôn ngữ trong tương lai sẽ mang lại trải nghiệm hài lòng hơn.