Tại sao phải dùng Graphics Card để nghiên cứu AI?

AI (Trí tuệ nhân tạo) đã và đang ngày càng trở thành một thứ không thể thiếu trong sự phát triển của công nghệ ngày nay. Đi cùng với sự phát triển đó là hoạt động nghiên cứu AI ngày càng nở rộ hơn ở khắp nơi trên thế giới !

Không chỉ có những trung tâm nghiên cứu lớn mới có thể nghiên cứu AI nữa, mà ngay cả những doanh nghiệp vừa và nhỏ hiện nay cũng hoàn toàn đủ sức để nghiên cứu và phát triển AI.

Ngoài vấn đề về nhân lực ra thì vấn đề về phần cứng để phục vụ cho công việc nghiên cứu này cũng đang ngày được phổ thông hóa hơn. Cụ thể là các Graphics Card cao cấp ngày nay đã tập trung và hỗ trợ cho việc nghiên cứu AI nhiều hơn…

Vậy bạn có bao giờ tự hỏi, tại sao các card đồ họa ngày càng được dùng nhiều trong lĩnh vực nghiên cứu AI không? Vâng, nếu bạn cũng đã từng thắc mắc như vậy thì hôm nay, chúng ta hãy cùng tìm hiểu về vấn đề này nhé.

Nội dung

Khái niệm cơ bản về AI

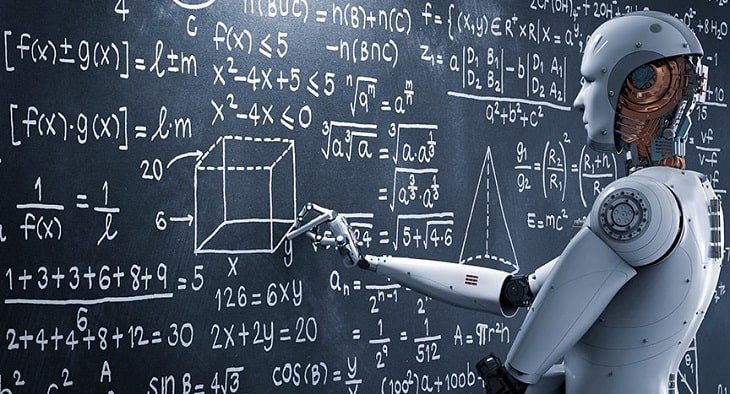

Tên đầy đủ của AI là Artificial Intelligence – trí thông minh nhân tạo. Về cơ bản thì đây là một chương trình do con người lập trình nên, kết hợp với Machine Learning (Học máy – lĩnh vực nghiên cứu) để tạo ra một AI hoàn chỉnh.

Thông thường, AI hoạt động dựa trên khối dữ liệu mà nhà lập trình nạp vào => sau đó nó dựa vào khối dữ liệu mà nó có được để đưa ra các thông tin, trả về kết quả tương ứng với mỗi trường hợp khác nhau.

Nghĩa là không có sự thần thánh gì ở đây cả, gần như những gì mà AI hiện tại làm được là nhờ vào những gì mà con người nạp vào cho nó. Hiển đơn giản vậy thôi các bạn !

Để nghiên cứu AI cần những gì?

Đầu tiên mình xin khẳng định, yếu tố cốt lõi nhất vẫn là con người. Thật vậy đấy, những trung tâm nghiên cứu AI cần phải có một đội ngũ nhân lực có trình độ cao về công nghệ thông tin (IT).

Ngoài đội ngũ lập trình chuyên môn cao ra, việc nghiên cứu AI còn cần đến các chuyên gia trong lĩnh vực máy học, xã hội học, thậm chí là con người học… nói chung là các loại học.

Bởi AI là trí tuệ nhân tạo, nó được tạo ra để làm những việc như con người, vậy nên những yếu tố như xã hội, hành vi con người đều phải được quan tâm và nó là nguồn dữ liệu quan trọng cho AI.

Thứ hai, tất nhiên rồi – đó là máy móc. Chắc hẳn chúng ta đã không ít lần nghe những câu chuyện về những thanh niên một mình, cùng với một chiếc máy tính cá nhân có thể viết ra cả một phần mềm đáng giá cả triệu đô.

Nhưng AI thì khác, nó có sự phức tạp và nguồn dữ liệu vô cùng lớn nên sẽ rất khó để một cá nhân có thể tự làm hoàn chỉnh được.

Và những chiếc máy tính phục vụ cho việc nghiên cứu AI luôn là những cỗ máy có cấu hình rất khủng và đặc biệt thường đi kèm đó là 3 – 4 card đồ họa cao cấp.

Tại sao chọn GPU (Graphics Card) để nghiên cứu AI?

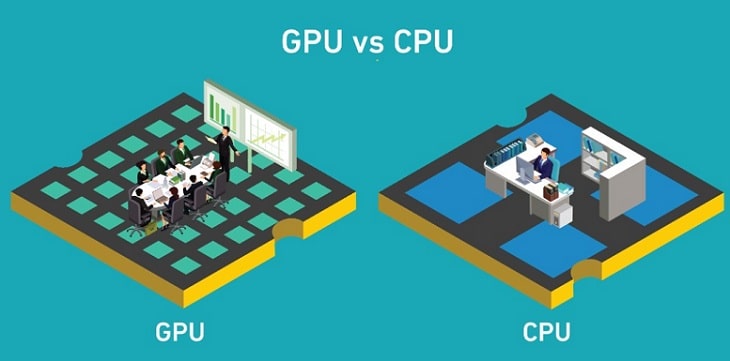

Đơn giản bởi vì GPU có khả năng xử lý các dữ liệu song song cùng lúc tốt hơn so với CPU !

Như mình đã nói ở trên, AI vốn là sự suy đoán từ nguồn dữ liệu nạp vào, vậy nên khối lượng công việc mà nói phải làm là rất “khổng lồ”, trong khi đó nó lại không cùng một hoạt động.

Chúng ta có một ví dụ về AI phân biệt màu sắc: dữ liệu nạp vào là những đặc điểm về màu, cụ thể là tính chất quang học của nó chẳng hạn.

Khi hệ thống phần cứng ghi lại hình ảnh màu sắc phía trước, lúc này nhờ vào những gì cảm biến thu nhận được thì AI sẽ bắt đầu so sánh với dữ liệu mình có được => và tiến hành đưa ra kết quả. Cách thức hoạt động này cũng tương tự với các hệ thống AI khác.

So sánh với ví dụ, có thể thấy khối lượng công việc khổng lồ là các đặc tính vật lý thu nhận được trên camera hay cảm biến, còn hoạt động chỉ là so sánh với dữ liệu mà nó có => sau đó thì đưa ra kết quả.

Tiếp theo nữa, với các card đồ họa cao cấp hiện nay, bộ nhớ Ram có dung lượng rất lớn và tốc độ là cực kì cao. Có thể kể đến card đồ họa RTX 3090 thuộc hàng TOP trên thị trường hiện nay với dung lương là 24GB GDDR6X, đi cùng với Bus là: 384-bit và Bandwidth (băng thông): 936 GBps.

Đây là một thông số rất ấn tượng, nó bảo đảm cho những dữ liệu lớn không bị delay và mọi thứ được xử lý một cách nhanh nhất có thể.

Một yếu tố không thể không kể đến nữa là sự hậu thuận từ các nhà sản xuất với việc thiết kế những nhân chuyên biệt bên trong card đồ họa.

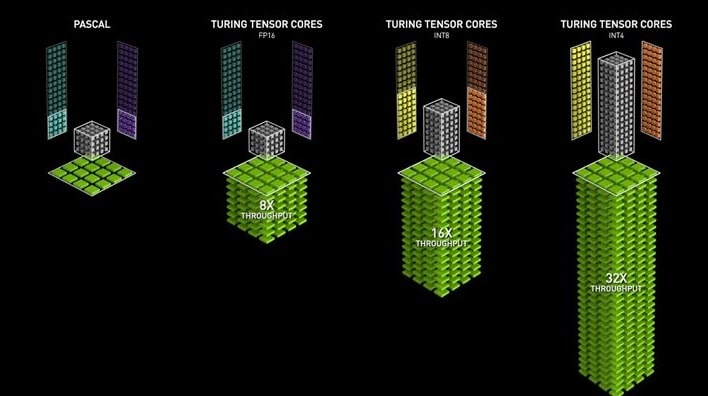

Gần đây nhất là nhân Tensor Core của Nvidia được chuyên biệt cho khả năng làm việc Deep Learning (một nhánh sâu hơn của Machine Learning).

Những cải tiến này giúp cho máy học trong vài tháng, nay chỉ còn vài tuần theo như những gì mà Nvidia công bố. Rút ngắn rất nhiều thời gian !

Vâng, như vậy là qua bài viết này thì chúng ta đã trả lời được cho câu hỏi: Tại sao các card đồ họa thường được dùng để nghiên cứu AI nhiều hơn là CPU rồi nhé.

Tuy nhiên, nhiều chuyên gia đang nỗ lực thử nghiệm và phát triển những cấu trúc lệnh mới trong lĩnh vực nghiên cứu Trí tuệ Nhân tạo (AI) nhằm nâng cao hiệu suất hoạt động trên CPU. Chúng tập trung vào việc tối ưu hóa và cải tiến các thuật toán và phương pháp xử lý dữ liệu để tận dụng tối đa khả năng của CPU.

Cấu trúc lệnh là một phần quan trọng trong việc xây dựng các mô hình AI. Nó xác định cách mà máy tính xử lý thông tin và thực hiện các tác vụ cụ thể. Hiện nay, các cấu trúc lệnh truyền thống trong AI tập trung chủ yếu vào việc tối ưu hóa hoạt động trên GPU (Graphical Processing Unit) nhưng không tận dụng hết tiềm năng của CPU.

Mặc dù GPU có thể xử lý một lượng lớn dữ liệu cùng một lúc và chạy nhanh hơn so với CPU trong một số tác vụ đặc thù, nhưng nó lại tiêu tốn nhiều năng lượng và không phải lúc nào cũng là lựa chọn tốt nhất cho mọi loại công việc. CPU có thể mang lại hiệu quả kinh tế tốt hơn bởi vì nó tiêu thụ ít năng lượng hơn và giá thành thấp hơn so với GPU.

Điều này làm cho CPU trở thành lựa chọn phù hợp cho các ứng dụng AI có quy mô nhỏ hoặc trong môi trường có hạn chế về tài nguyên. Với mục tiêu tận dụng tối đa khả năng của CPU, các chuyên gia đã đề xuất và thử nghiệm những cấu trúc lệnh mới cho AI. Các cấu trúc lệnh này được thiết kế dựa trên nguyên tắc tiết kiệm năng lượng và tối ưu hoá hiệu suất tính toán trên CPU.

Chúng tập trung vào việc phân bổ các tác vụ tính toán một cách thông minh và sử dụng các thuật toán tối ưu để giảm thiểu thời gian xử lý. Ngoài ra, các chuyên gia cũng đang nghiên cứu và phát triển các phương pháp tăng cường khả năng xử lý dữ liệu trên CPU.

Điều này bao gồm sử dụng kỹ thuật đa luồng (multithreading) để thực hiện đa nhiệm và xử lý song song nhiều tác vụ cùng một lúc trên CPU. Các kỹ thuật này giúp tận dụng tối đa sức mạnh tính toán của CPU và cải thiện hiệu suất hoạt động của các ứng dụng AI.

Tổng kết lại, việc nghiên cứu và phát triển những cấu trúc lệnh mới trong AI nhằm cải thiện hiệu suất hoạt động trên CPU là một hướng đi đáng chú ý và triển vọng. Sự tập trung vào việc tối ưu hoá và cải tiến các thuật toán và phương pháp xử lý dữ liệu trên CPU đã mở ra những cánh cửa mới cho phát triển AI trên nền tảng CPU. V